Edge Cihazlarda YOLOv8 ile Gerçek Zamanlı Nesne Tespiti: Docker ve NVIDIA Jetson Üzerinde Performans Optimizasyonu

Giriş: Edge AI ve Gerçek Zamanlı Nesne Tespitinin Yükselişi

Yapay zeka modellerinin, verilerin oluşturulduğu noktaya, yani “edge” cihazlara taşınması, düşük gecikme süresi, artırılmış gizlilik ve bant genişliği tasarrufu gibi kritik avantajlar sunar. Bu paradigmanın en güçlü uygulamalarından biri de nesne tespitidir. Özellikle otonom sistemler, akıllı şehirler ve endüstriyel otomasyon gibi alanlarda gerçek zamanlı nesne tespiti vazgeçilmez bir ihtiyaç haline gelmiştir. Ultralytics tarafından geliştirilen YOLOv8, hızı ve doğruluğuyla öne çıkan, bu tür zorlu edge ortamları için ideal bir çözümdür. Ancak, bu modelleri kısıtlı kaynaklara sahip edge cihazlarda en yüksek verimlilikle çalıştırmak, dikkatli bir optimizasyon süreci gerektirir.

Bu blog yazısında, özellikle NVIDIA Jetson platformunda YOLOv8 modelini Docker konteynerleri kullanarak nasıl dağıtacağınızı ve performansını TensorRT gibi araçlarla nasıl optimize edeceğinizi adım adım inceleyeceğiz. Amacımız, projelerinizde gerçek zamanlı ve yüksek performanslı nesne tespiti elde etmeniz için size pratik bilgiler ve stratejiler sunmaktır.

İçindekiler

- YOLOv8 ve Edge Cihazlarda Nesne Tespiti Neden Önemli?

- NVIDIA Jetson: Edge AI İçin İdeal Platform

- Docker ile Kapsamlı ve Optimize Dağıtım

- Performans Optimizasyonu Stratejileri

- Jetson ve Docker Üzerinde YOLOv8 Kurulum Adımları (Özet)

- Sıkça Sorulan Sorular (SSS)

- Sonuç

YOLOv8 ve Edge Cihazlarda Nesne Tespiti Neden Önemli?

YOLO (You Only Look Once) serisi, tek aşamalı nesne tespit mimarisi sayesinde sektörde çığır açmıştır. YOLOv8 ise önceki versiyonların üzerine inşa ederek hem daha yüksek doğruluk hem de daha hızlı çıkarım süreleri sunmaktadır. Bu özellikleriyle, hızın kritik olduğu gerçek zamanlı uygulamalarda tercih sebebi olmaktadır. Edge cihazlar ise sensörlerden gelen veriyi doğrudan işleyerek, verinin buluta gönderilmesinin getirdiği gecikmeyi ve maliyeti ortadan kaldırır. Bu birleşim, özellikle güvenlik kameralarından canlı görüntü analizi, robotik navigasyon ve insansız hava araçları gibi uygulamalar için hayati önem taşır.

"Edge computing, yapay zekayı verinin kaynağına taşıyarak, gecikmeyi azaltır ve otonom sistemler için yeni olanaklar yaratır."

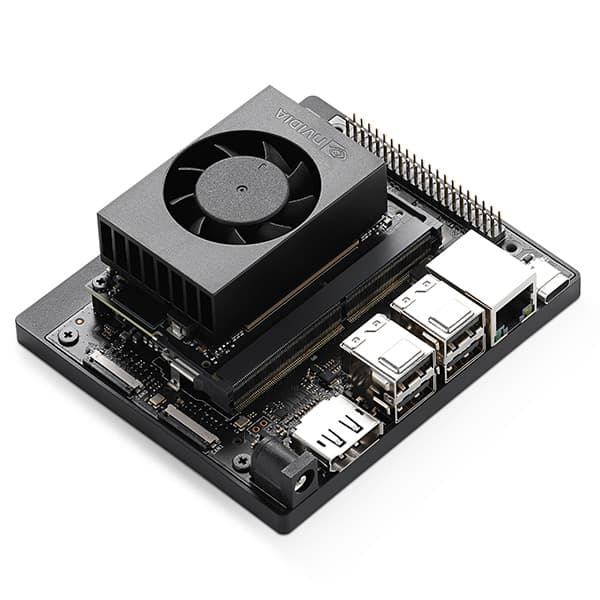

NVIDIA Jetson: Edge AI İçin İdeal Platform

NVIDIA Jetson serisi, güçlü GPU’ları ve düşük güç tüketimiyle yapay zeka ve makine öğrenimi iş yükleri için özel olarak tasarlanmış gömülü sistemlerdir. Jetson Nano‘dan Jetson AGX Orin‘e kadar farklı modeller, çeşitli performans ve maliyet ihtiyaçlarına uygun çözümler sunar. Jetson cihazlar, NVIDIA’nın CUDA, cuDNN ve TensorRT gibi optimizasyon kütüphaneleriyle tam uyumludur. Bu entegrasyon, derin öğrenme modellerinin GPU üzerinde inanılmaz hızlarda çalışmasını sağlar ve özellikle nesne tespiti gibi yoğun hesaplama gerektiren görevler için biçilmiş kaftandır.

Docker ile Kapsamlı ve Optimize Dağıtım

Docker konteynerleri, yazılım uygulamalarını tüm bağımlılıklarıyla birlikte izole edilmiş ve taşınabilir bir ortamda paketlemenizi sağlar. Bu, özellikle farklı Python sürümleri, kütüphane versiyonları (örn. PyTorch, TensorFlow) ve CUDA gereksinimleri olan AI projelerinde bağımlılık karmaşasını çözmek için kritik öneme sahiptir. Jetson cihazlarda Docker kullanmanın başlıca faydaları şunlardır:

- Ortam Tutarlılığı: Geliştirme, test ve dağıtım ortamları arasında tutarlılık sağlar.

- İzolasyon: Farklı projelerin çakışan bağımlılıkları olmadan aynı Jetson üzerinde çalışmasına olanak tanır.

- Taşınabilirlik: Bir Jetson üzerinde oluşturulan Docker imajı, diğer Jetson cihazlarda kolayca dağıtılabilir.

- Sürüm Kontrolü: Belirli bir AI modelini ve onun tüm bağımlılıklarını içeren bir konteyner imajının versiyonlamasını kolaylaştırır.

NVIDIA Container Toolkit sayesinde, Docker konteynerleri içinden Jetson’ın GPU kaynaklarına doğrudan erişim sağlanabilir, bu da performans kaybı olmaksızın GPU hızlandırmalı uygulamaların çalışmasını mümkün kılar.

Performans Optimizasyonu Stratejileri

YOLOv8’i Jetson ve Docker üzerinde en yüksek performansla çalıştırmak için birden fazla optimizasyon tekniğini birleştirmek gerekir.

TensorRT Entegrasyonu

NVIDIA TensorRT, derin öğrenme modelleri için yüksek performanslı çıkarım optimizasyonudur. Model grafiklerini optimize ederek, katman füzyonu yaparak ve hassaslık düşürme (quantization) teknikleri uygulayarak çıkarım hızını önemli ölçüde artırır. YOLOv8 modellerini ONNX formatına dönüştürdükten sonra TensorRT motorunda derlemek, Jetson üzerinde maksimum hız elde etmenin anahtarlarından biridir.

Donanım Optimizasyonu (GPU ve RAM Kullanımı)

Jetson cihazlarda GPU ve RAM kullanımını etkin bir şekilde yönetmek çok önemlidir. Jetson’ın sağladığı araçlarla (örn. tegrastats) GPU kullanımını ve güç tüketimini izleyerek, modelin donanım limitlerini zorlamadığından emin olunmalıdır. Ayrıca, gereksiz arka plan süreçlerini kapatmak ve bellek verimli kod yazmak performansı artırabilir.

Veri Önişleme ve Artımlı İşleme

Nesne tespit modeline beslenen görüntülerin önişleme adımları (yeniden boyutlandırma, normalizasyon vb.) CPU’da zaman alıcı olabilir. Bu adımları GPU’da veya çoklu iş parçacığı kullanarak paralel çalıştırmak performansı iyileştirebilir. Ayrıca, mümkünse görüntüleri küçük partiler (batch) halinde işlemek, GPU kullanımını daha verimli hale getirir.

Model Kuantizasyonu

Model kuantizasyonu, modelin ağırlıklarını ve aktivasyonlarını daha düşük hassasiyetli veri tiplerine (örn. 32-bit float yerine 16-bit float veya 8-bit integer) dönüştürme işlemidir. Bu, model boyutunu küçültür ve çıkarım hızını artırır. Jetson cihazlar, özellikle TensorRT ile birlikte INT8 kuantizasyonunu destekleyerek önemli performans artışları sağlayabilir. YOLOv8, belirli modeller için kuantizasyon seçenekleri sunmaktadır.

Çoklu İş Parçacığı ve Paralel İşleme

Jetson’ın çok çekirdekli CPU’sundan ve GPU’sundan aynı anda yararlanmak performansı artırır. Örneğin, bir iş parçacığı bir sonraki görüntüyü önceden işlerken, diğeri mevcut görüntüyü GPU’da işleyebilir. Bu tür paralel işleme stratejileri, darboğazları ortadan kaldırarak genel sistem verimini artırır.

Jetson ve Docker Üzerinde YOLOv8 Kurulum Adımları (Özet)

Bu bölümde, bahsedilen stratejileri uygulamak için atmanız gereken genel adımları özetliyoruz:

- Jetson İşletim Sistemi ve JetPack Kurulumu: NVIDIA JetPack SDK’sını kullanarak Jetson cihazınıza işletim sistemini ve tüm gerekli kütüphaneleri (CUDA, cuDNN, TensorRT) kurun.

- Docker ve NVIDIA Container Toolkit Kurulumu: Jetson’ınızda Docker’ı ve GPU desteği için NVIDIA Container Toolkit’i kurun. Bu, Docker konteynerlerinin GPU’ya erişmesini sağlar.

- YOLOv8 için Optimize Edilmiş Docker İmajı Oluşturma: Python, PyTorch (veya TensorFlow), Ultralytics kütüphanelerini ve TensorRT uyumlu çalışma zamanı ortamını içeren özel bir Dockerfile oluşturun. Bu Dockerfile, YOLOv8 modelini çalıştırmak için gerekli tüm bağımlılıkları içermelidir.

- Modeli Dışa Aktarma ve TensorRT İle Derleme: YOLOv8 modelini ONNX formatına dışa aktarın ve ardından TensorRT’nin

trtexecaracı veya Python API’leri aracılığıyla Jetson için optimize edilmiş bir TensorRT motoruna dönüştürün. - Çıkarım ve Performans İzleme: Optimize edilmiş TensorRT motorunu kullanarak YOLOv8 modelini Docker konteyneri içinde çalıştırın. Bu aşamada,

tegrastatsgibi araçlarla GPU kullanımını ve çıkarım sürelerini yakından izleyerek performans ayarlamaları yapın.

Sıkça Sorulan Sorular (SSS)

Docker kullanmak performans kaybına neden olur mu?

Genellikle, Docker’ın kendisi çok minimal bir performans yükü getirir. NVIDIA Container Toolkit ile GPU erişimi doğrudan sağlandığı için, GPU hızlandırmalı uygulamalarda ihmal edilebilir bir performans farkı olur. Bağımlılık yönetimi ve taşınabilirlik gibi faydaları, bu küçük yükü fazlasıyla dengeler.

Hangi Jetson modeli YOLOv8 için en uygunudur?

Bu, projenizin bütçesine, güç tüketimi kısıtlamalarına ve beklediğiniz performans seviyesine bağlıdır. Jetson Nano giriş seviyesi projeler için uygundur, ancak daha yüksek kare hızları ve karmaşık modeller için Jetson Xavier NX veya Jetson AGX Orin gibi daha güçlü modeller tercih edilmelidir. AGX Orin, en zorlu gerçek zamanlı AI görevleri için en yüksek performansı sunar.

TensorRT entegrasyonu ne kadar zor?

TensorRT entegrasyonu başlangıçta biraz karmaşık gelebilir, ancak Ultralytics kütüphanesi ve NVIDIA’nın sağladığı dokümantasyonlar bu süreci basitleştirmektedir. YOLOv8 modellerini ONNX’e dönüştürdükten sonra TensorRT motoruna aktarma adımları genellikle iyi belgelenmiştir. Zamanla pratik yaparak bu sürece hakim olabilirsiniz.

Sonuç

Edge cihazlarda YOLOv8 ile gerçek zamanlı nesne tespiti, modern AI uygulamalarının temel taşlarından biridir. NVIDIA Jetson’ın güçlü donanımı ve Docker’ın esnek dağıtım yetenekleri, bu tür projeler için mükemmel bir temel sağlar. TensorRT entegrasyonu, model kuantizasyonu ve akıllı veri işleme gibi optimizasyon stratejileriyle birleştiğinde, kısıtlı kaynaklara sahip edge ortamlarında bile etkileyici performans elde etmek mümkündür.

Bu rehberdeki bilgilerle, kendi YOLOv8 tabanlı nesne tespit projelerinizde performansı artırma ve uygulamalarınızı gerçek dünya senaryolarına taşıma konusunda kendinize güven duyabilirsiniz. Unutmayın, en iyi sonuçlar genellikle sürekli deneme, izleme ve ince ayarlarla elde edilir. Şimdiden başarılar!

Bunları da beğenebilirsiniz

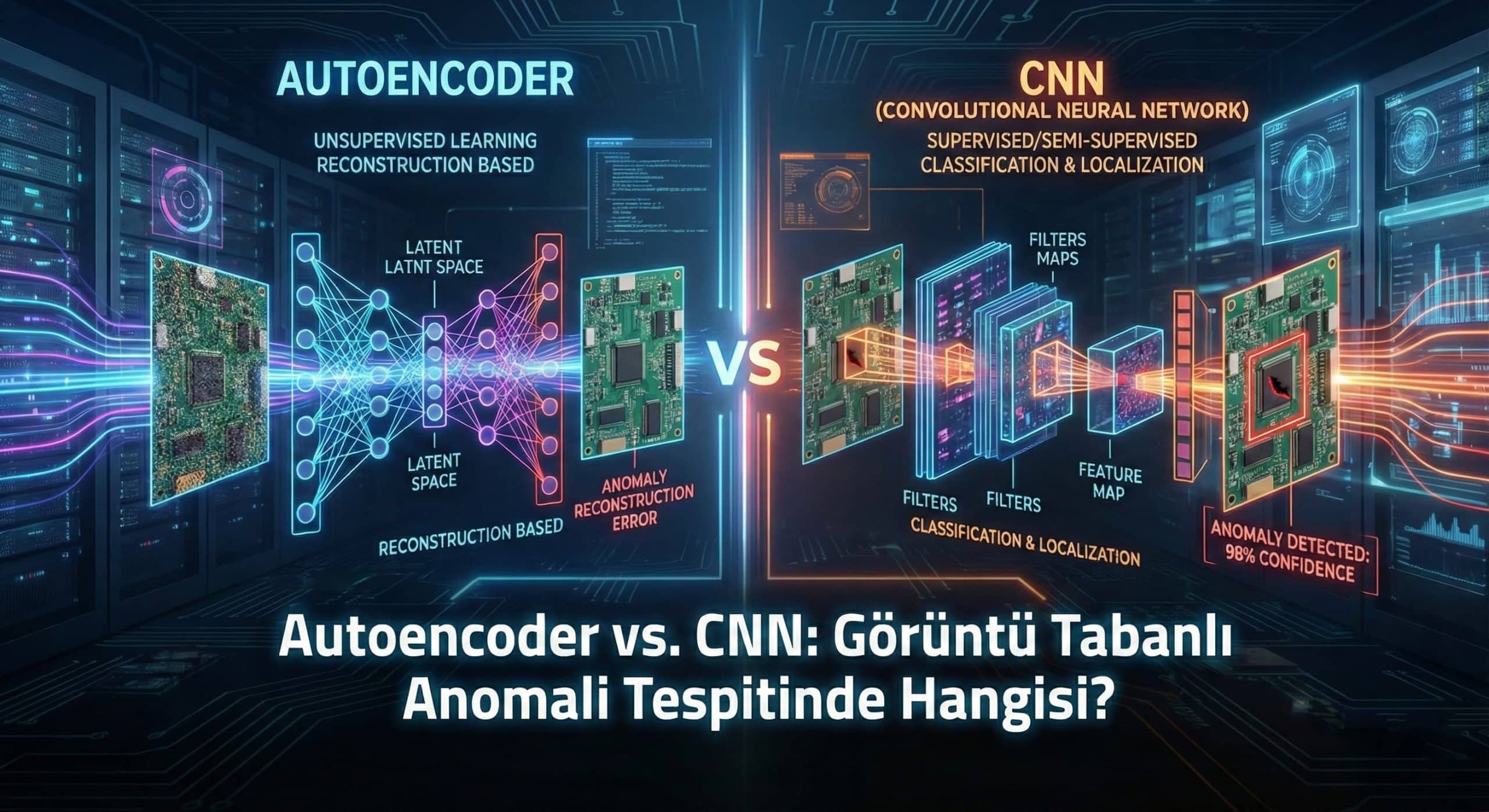

Autoencoder Modelleri için PyTorch mu TensorFlow mu? 2026 Yılı İçin En İyi Seçim

Derin öğrenme alanında Autoencoder’lar, veri sıkıştırma, anomali tespiti ve özellik öğrenimi gibi birçok kritik görevde kilit rol oynamaktadır. Bu güçlü modelleri eğitirken karşılaşılan temel sorulardan…

PHP ile Merkez Bankası Kurlarını Çekmek

Merhabalar, web uygulamaları geliştirirken, çeşitli finansal verilere ihtiyaç duyabiliriz. Özellikle, kullanıcılarımızın döviz kurlarına erişebilmesini sağlamak istediğimiz durumlar olabilir. Bu noktada, Merkez Bankası’nın sağladığı güncel kurları…